هوش مصنوعی: حبابی در آستانه ترکیدن یا انقلابی پایدار

به گزارش گروه دانشگاه خبرگزاری دانشجو، بین خوشبینی، قرار گرفتن در معرض بیش از حد، آگاهی از محدودیتهای آنها و سرخوردگی، سیستمهای هوش مصنوعی هنوز تاثیر محدودی دارند. هوش مصنوعی (AI) اغلب به عنوان انقلاب بعدی معرفی میشود که زندگی ما را متحول میکند. از زمان راه اندازی ChatGPT در سال 2022، هوش مصنوعی مولد شور و شوق جهانی را برانگیخته است. در سال 2023، NVidia، یک بازیگر کلیدی در تولید...

به گزارش گروه دانشگاه خبرگزاری دانشجو، بین خوشبینی، قرار گرفتن در معرض بیش از حد، آگاهی از محدودیتهای آنها و سرخوردگی، سیستمهای هوش مصنوعی هنوز تاثیر محدودی دارند.

هوش مصنوعی (AI) اغلب به عنوان انقلاب بعدی معرفی میشود که زندگی ما را متحول میکند. از زمان راه اندازی ChatGPT در سال 2022، هوش مصنوعی مولد شور و شوق جهانی را برانگیخته است. در سال 2023، NVidia، یک بازیگر کلیدی در تولید تراشههای مورد استفاده برای آموزش مدلهای هوش مصنوعی، از ارزش بازار 1 تریلیون دلار فراتر رفت؛ و سال بعد از 3 تریلیون دلار گذشت.

اما این شور و شوق با تردیدهایی همراه است. در واقع، در حالی که هوش مصنوعی در کانون توجه رسانهها قرار دارد، تأثیر اقتصادی مشخص آن کم است و پذیرش آن توسط مشاغل محدود است. یک مطالعه اخیر تخمین میزند که تنها 5 درصد از شرکتها به طور فعال از فناوریهای هوش مصنوعی در فرآیندهای خود استفاده میکنند، چه هوش مصنوعی مولد، چه تجزیه و تحلیل پیشبینیکننده یا سیستمهای اتوماسیون. در برخی موارد، هوش مصنوعی حتی متهم به منحرف کردن توجه رهبران از مسائل عملیاتی فوری است. این شکاف بین انتظارات و نتایج ملموس این سوال را مطرح میکند: آیا هوش مصنوعی به سادگی از یک "چرخه تبلیغات"عبور میکند، جایی که اشتیاق بیش از حد به سرعت با سرخوردگی همراه میشود، همانطور که در سایر فناوریها از دهه 90 مشاهده شد؟ یا شاهد کاهش واقعی علاقه به این فناوری میشویم؟

از خاستگاه هوش مصنوعی تا ChatGPT: امواج خوشبینی و پرسشها

تاریخچه هوش مصنوعی با چرخههایی از خوش بینی و بدبینی مشخص شده است. در اوایل دهه 1950، محققان آیندهای پر از ماشینهایی را تصور میکردند که میتوانستند به اندازه انسانها به طور مؤثری فکر کنند و مسائل را حل کنند. این اشتیاق به وعدههای بلندپروازانهای منجر شد، مانند ایجاد سیستمهایی که قادر به ترجمه خودکار هر زبانی یا درک کامل زبان انسان باشند.

با این حال، با توجه به محدودیتهای تکنولوژیکی آن زمان، این انتظارات غیر واقعی بود. بنابراین، اولین ناامیدیها منجر به "زمستانهای هوش مصنوعی" در اواخر دهه 1970 و اواخر دهه 1980 شد، دورههایی که بودجه به دلیل ناتوانی فناوریها در تحقق وعدههای داده شده کاهش یافت.

با این حال، دهه 1990 به لطف سه عنصر کلیدی، نقطه عطف مهمی بود: انفجار دادههای بزرگ، افزایش قدرت محاسباتی، و ظهور الگوریتمهای کارآمدتر. اینترنت جمع آوری عظیم دادهها را تسهیل کرد که برای آموزش مدلهای یادگیری ماشین ضروری است. این مجموعه دادههای وسیع بسیار مهم هستند، زیرا نمونههای مورد نیاز هوش مصنوعی برای "یادگیری" و انجام وظایف پیچیده را ارائه میکنند. در همان زمان، پیشرفت در پردازندهها امکان اجرای الگوریتمهای پیشرفته مانند شبکههای عصبی عمیق را که پایه و اساس یادگیری عمیق هستند را ممکن ساخت. آنها توسعه هوش مصنوعی را قادر ساختند که بتواند کارهایی را که قبلاً دور از دسترس بودند، مانند تشخیص تصویر و تولید خودکار متن، انجام دهد.

این قابلیتهای افزایشیافته امیدها را برای انقلابی که پیشگامان این حوزه پیشبینی میکردند، زنده کرد و هوش مصنوعی برای بسیاری از وظایف در همه جا حاضر و مؤثر شد. با این حال، آنها همچنین با چالشها و خطرات عمدهای همراه هستند که شروع به کاهش شور و شوق پیرامون هوش مصنوعی میکند.

تحقق تدریجی محدودیتهای فنی که بر آینده هوش مصنوعی تاثیر میگذارد

اخیراً، ذینفعانی که به توسعه هوش مصنوعی توجه دارند، از محدودیتهای سیستمهای فعلی آگاه شدهاند که میتواند مانع پذیرش آنها و محدود کردن نتایج مورد انتظار شود.

اولاً، مدلهای یادگیری عمیق به دلیل پیچیدگیشان اغلب به عنوان «جعبههای سیاه» توصیف میشوند و توضیح تصمیمهایشان را دشوار میکنند. این عدم شفافیت میتواند اعتماد کاربر را کاهش دهد و پذیرش را به دلیل ترس از خطرات اخلاقی و قانونی محدود کند.

سوگیریهای الگوریتمی یکی دیگر از مسائل مهم است. سیستمهای هوش مصنوعی فعلی از حجم وسیعی از دادهها استفاده میکنند که به ندرت عاری از سوگیری هستند؛ بنابراین هوش مصنوعی این سوگیریها را در نتایج خود بازتولید میکند، همانطور که در مورد الگوریتم استخدام آمازون که به طور سیستماتیک علیه زنان تبعیض قائل شد. چندین شرکت به دلیل سوگیریهای شناسایی شده در سیستم هایشان مجبور به عقب نشینی شدهاند. به عنوان مثال، مایکروسافت چت ربات Tay خود را پس از ایجاد اظهارات تنفر آمیز کنار کشید، در حالی که گوگل ابزار تشخیص چهره خود را که برای افراد رنگین پوست موثر نبود، به حالت تعلیق درآورد.

این خطرات باعث میشود که برخی از شرکتها تمایلی به اتخاذ این سیستمها نداشته باشند، زیرا میترسند به اعتبار آنها آسیب وارد شود.

ردپای زیست محیطی هوش مصنوعی نیز نگران کننده است. مدلهای پیشرفته به قدرت محاسباتی قابل توجهی نیاز دارند و مصرف انرژی زیادی تولید میکنند. به عنوان مثال، آموزش مدلهای بزرگ مانند GPT-3 به اندازه 5 سفر رفت و برگشت بین نیویورک و سانفرانسیسکو (تقریباً 2500 مایل در هر طرف) CO2 منتشر میکند. در زمینه مبارزه با تغییرات اقلیمی، این سوال در مورد ارتباط استقرار در مقیاس بزرگ این فناوریها ایجاد میکند.

به طور کلی، این محدودیتها توضیح میدهند که چرا برخی از انتظارات اولیه، مانند وعده اتوماسیون گسترده و قابل اعتماد، به طور کامل محقق نشده است و با چالشهای مشخصی مواجه است که میتواند اشتیاق به هوش مصنوعی را کاهش دهد.

به سوی پذیرش سنجیده و تنظیم شده هوش مصنوعی؟

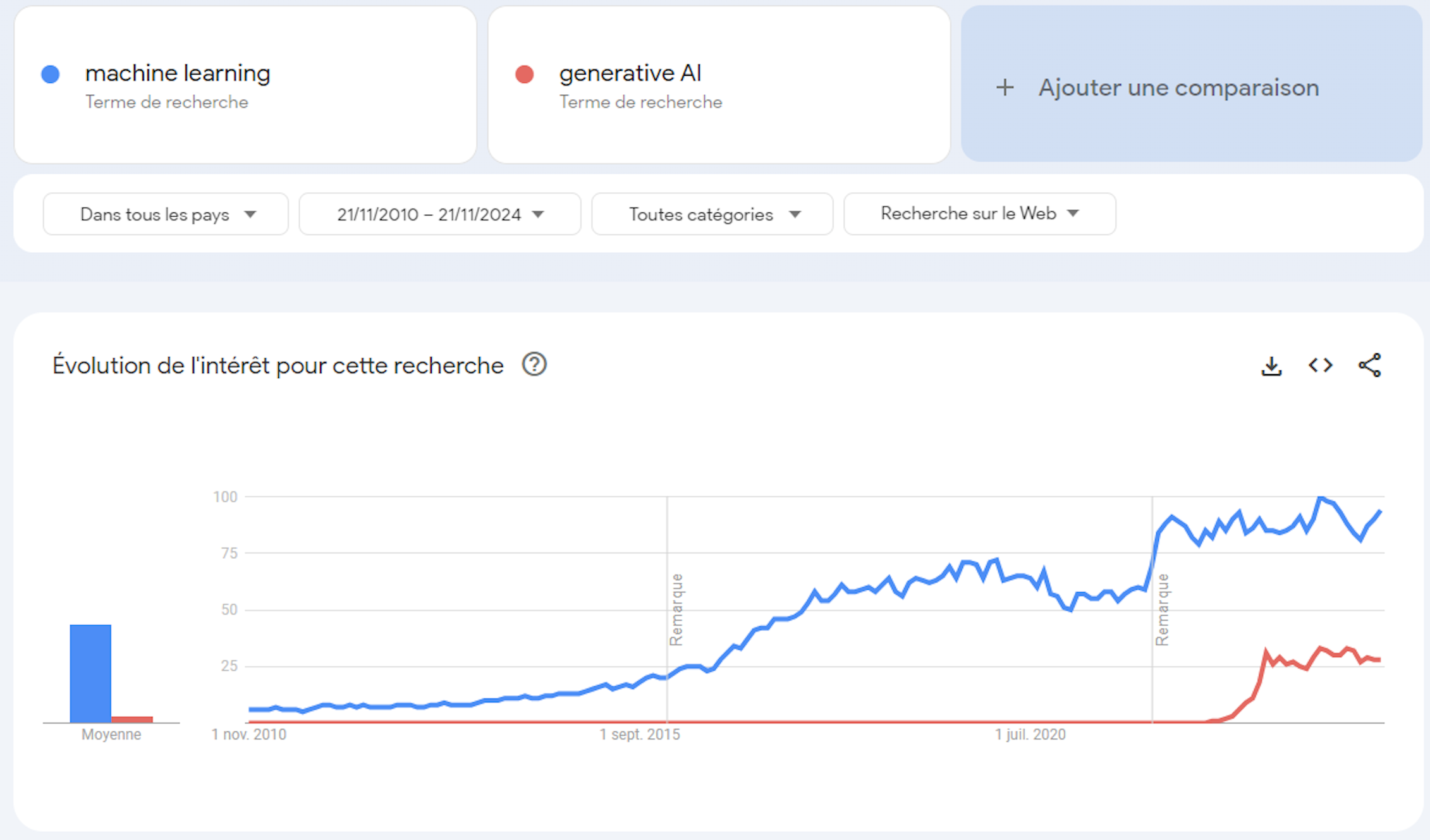

هوش مصنوعی که در حال حاضر به خوبی در زندگی روزمره ما ادغام شده است، به نظر میرسد برای ناپدید شدن بیش از آن جا افتاده است و «زمستان هوش مصنوعی» مانند زمستانهای دهه 1970 و 1980 را بعید میسازد. برخی از ناظران به جای کاهش پایدار در این فناوری، ظهور یک حباب را پیشنهاد میکنند. هیاهو، که با استفاده مکرر از اصطلاح "انقلاب" تقویت شده است، در واقع به هیجان اغلب نامتناسب و تشکیل حباب خاصی کمک کرده است. ده سال پیش، یادگیری ماشینی بود. امروز، این هوش مصنوعی مولد است. مفاهیم مختلف به نوبه خود رایج شدهاند که هر یک نوید یک انقلاب جدید فناوری را میدهد.

با این حال هوش مصنوعی مدرن از یک "انقلاب" فاصله زیادی دارد: این بخشی از تداوم تحقیقات گذشته است که توسعه مدلهای پیچیده تر، کارآمدتر و مفیدتر را امکان پذیر کرده است.

با این حال، این پیچیدگی به دور از اعلامیههای پر زرق و برق، هزینه عملی دارد. در واقع، پیچیدگی مدلهای هوش مصنوعی تا حدودی توضیح میدهد که چرا بسیاری از شرکتها پذیرش هوش مصنوعی را دشوار میدانند. مدلهای هوش مصنوعی که اغلب بزرگ هستند و تسلط بر آنها دشوار است، به زیرساختهای اختصاصی و تخصص کمیاب نیاز دارند که بسیار پرهزینه هستند؛ بنابراین استقرار سیستمهای هوش مصنوعی هم از نظر مالی و هم از نظر انرژی میتواند پرهزینهتر از سودمند باشد. به عنوان مثال، تخمین زده میشود که الگوریتمی مانند ChatGPT به دلیل محاسبات و منابع انرژی بسیار مورد نیاز، روزانه 700000 دلار هزینه دارد. به این سوال نظارتی نیز اضافه شده است. اصولی مانند به حداقل رساندن جمع آوری دادههای شخصی، مورد نیاز GDPR، با ماهیت هوش مصنوعی فعلی در تضاد است. قانون هوش مصنوعی که از آگوست 2024 اجرا میشود، میتواند توسعه این سیستمهای پیچیده را نیز به چالش بکشد. نشان داده شده است که هوش مصنوعی مانند OpenAI's GPT-4 یا Google's PaLM2، 12 الزامات کلیدی این قانون را برآورده نمیکند. این عدم انطباق میتواند روشهای فعلی توسعه هوش مصنوعی را زیر سوال ببرد و بر استقرار آنها تأثیر بگذارد.

همه این دلایل میتواند منجر به ترکیدن این حباب هوش مصنوعی شود و ما را بر آن دارد تا در مورد نمایش اغراق آمیز پتانسیل آن در رسانهها تجدید نظر کنیم؛ بنابراین لازم است رویکردی ظریفتر اتخاذ کنیم و گفتمان را به سمت دیدگاههای واقعیتر و ملموستر هدایت کنیم که محدودیتهای این فناوریها را تشخیص میدهند.

این آگاهی همچنین باید ما را به سمت توسعه سنجیدهتر هوش مصنوعی هدایت کند، با سیستمهایی که مناسبتر با نیازهای ما هستند و خطرات کمتری برای جامعه دارند.