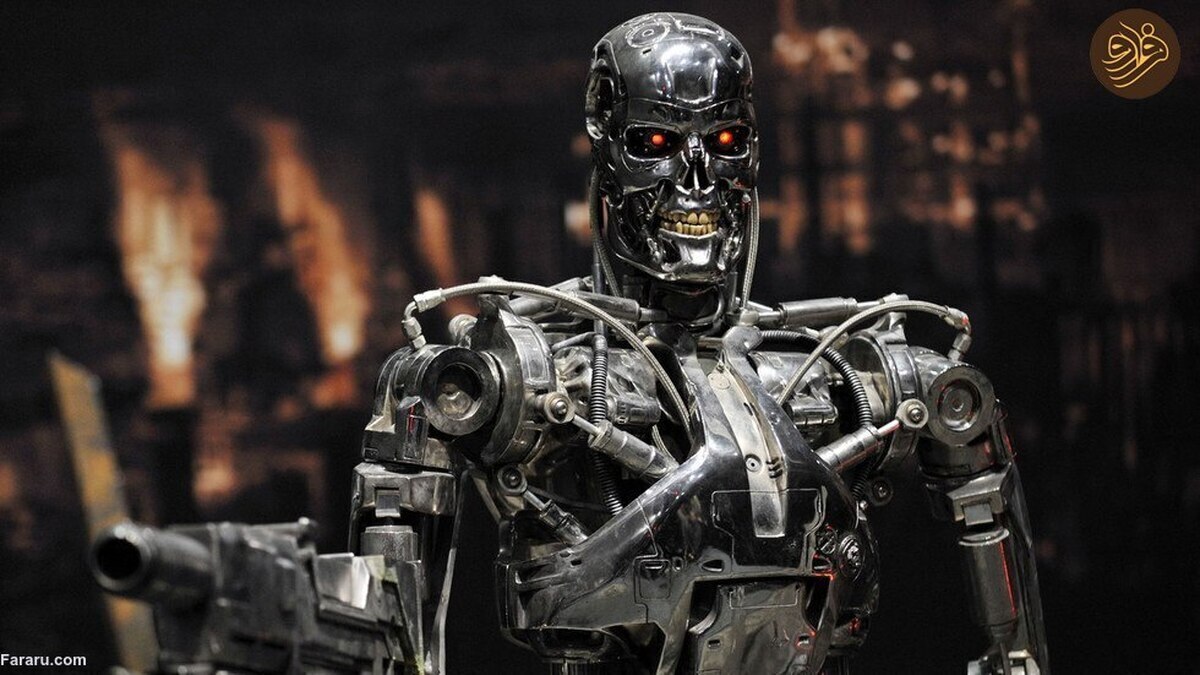

محتملترین نتیجه هوش مصنوعی فوقالعاده هوشمند: همه خواهیم مرد!

"الیزر یودکوفسکی" میگوید بشریت برای زنده ماندن از رویارویی با هوش مصنوعی بسیار هوشمندتر آماده نیست.

یک محقق برجسته هوش مصنوعی هشدار داد که متوقف کردن توسعه سیستمهای هوش مصنوعی پیشرفته در سراسر جهان و مجازات شدید افرادی که این مهلت قانونی را نقض میکنند تنها راه نجات بشریت از انقراض است.

به گزارش فرارو به نقل از راشاتودی؛ "الیزر یودکوفسکی" یکی از بنیانگذاران موسسه تحقیقاتی هوش ماشینی (MIRI) روز چهارشنبه در مقالهای نظری برای نشریه "تایم" توضیح داد که چرا طوماری را امضا نکرده است که از تمام آزمایشگاههای هوش مصنوعی میخواهد که فورا حداقل برای شش ماه آموزش سیستمهای هوش مصنوعی قویتر از جی پی تی -4 (یک مدل زبان بزرگ چند وجهی است که اوایل ماه جاری توسط Open AI منتشر شد) را متوقف کنند.

یودکوفسکی استدلال کرد که نامه امضا شده توسط افرادی مانند ایلان ماسک و استیو وزنیاک مدیر اپل برای حل مشکلی که به دلیل توسعه سریع و کنترل نشده هوش مصنوعی ایجاد میشود بسیار ناچیز است.

الیزر یودکوفسکی؛ محقق برجسته هوش مصنوعی

او نوشت: "محتملترین نتیجه ساخت یک هوش مصنوعی فوق العاده هوشمند تحت هر چیزی که از راه دور مانند شرایط کنونی باشد این است که به معنای واقعی کلمه همه روی زمین خواهند مرد".

او استدلال کرد که زنده ماندن از رویارویی با یک سیستم کامپیوتری که "نه برای ما و نه به طور کلی برای زندگی حساس" است به "دقت و آمادگی و بینشهای علمی جدید" نیاز دارد که بشر در حال حاضر فاقد آن میباشد و بعید به نظر میرسد در آینده قابل پیش بینی نیز به آن دست یابد.

یودکووسکی هشدار داد: "یک هوش مصنوعی به اندازه کافی هوشمند برای مدت طولانی در رایانه محصور نخواهد شد". او توضیح داد که این واقعیت که امکان ارسال رشتههای DNA به آزمایشگاهها برای تولید پروتئین وجود دارد احتمالا به هوش مصنوعی این امکان را میدهد که اشکال حیات مصنوعی را بسازد یا مستقیما به سمت تولید مولکولی پسا بیولوژیکی حرکت کند و به جهان راه یابد.

به گفته این محقق یک مهلت نامعلوم و جهانی برای دورههای آموزشی اصلی جدید هوش مصنوعی باید فورا معرفی شود. او تاکید کرد: "هیچ استثنایی نمیتواند وجود داشته باشد از جمله برای دولتها یا ارتشها".

یودوفسکی تاکید کرده که قراردادهای بینالمللی باید امضا شوند تا سقفی در مورد میزان قدرت محاسباتی که هر فردی ممکن است از آن در آموزش چنین سیستمهایی استفاده کند تعیین شود.

او در مقاله اشاره کرده که تهدید هوش مصنوعی به قدری زیاد است باید "در دیپلماسی بین المللی به صراحت اعلام شود که جلوگیری از سناریوهای انقراض توسط هوش مصنوعی اولویتی بالاتر از جلوگیری از تبادل کامل هستهای است".

تماشاخانه

رقابت و حذف دیگری در ایران؛ چرا تحمل نظر مخالف را نداریم؟ (فیلم)

چرا ارتش در بهمن سال 57 اعلام بیطرفی کرد؟ چرا کودتا نشد؟ (فیلم)

فیلم های دیگر docReady(function () { if (window.innerWidth کانال عصر ایران در تلگرام